DeepLearning

DeepLearning 【ゼロつく学習記録】Batch Normalizationを理解する

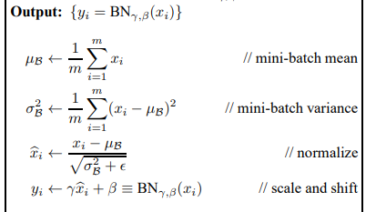

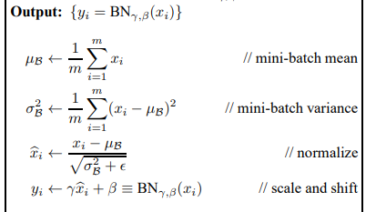

Batch Normalizationとは

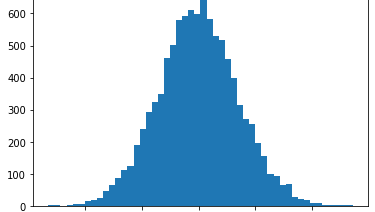

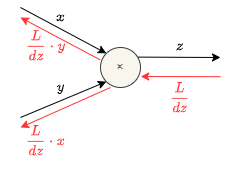

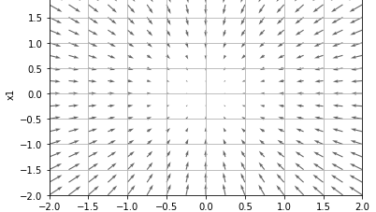

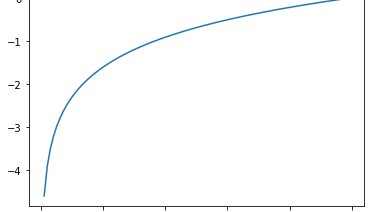

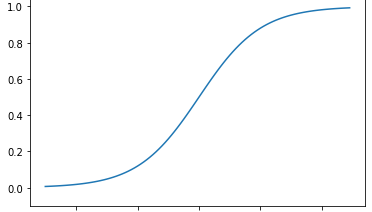

Batch Normalizationとは各層のアクティベーションの文を適度な広がりを持つように調整する手法です。

特徴として大きく以下の3点があります。

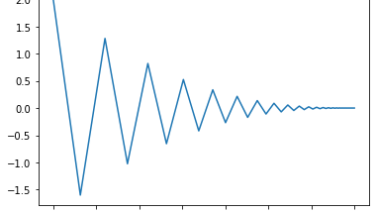

①学習を早く進行させ...

DeepLearning

DeepLearning  DeepLearning

DeepLearning  DeepLearning

DeepLearning  DeepLearning

DeepLearning  DeepLearning

DeepLearning  DeepLearning

DeepLearning  DeepLearning

DeepLearning  DeepLearning

DeepLearning  DeepLearning

DeepLearning